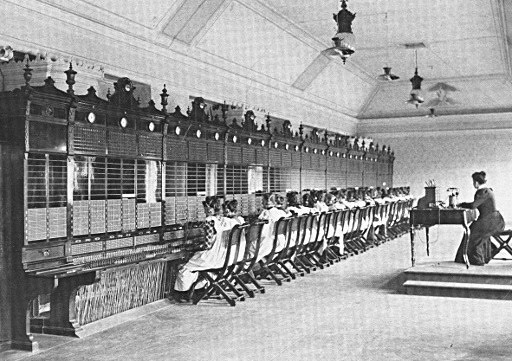

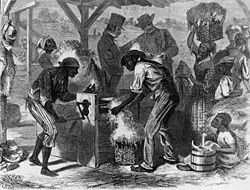

La técnica del técnico consiste, invece, nel “saper far fare” e per questo motivo si adatta bene al periodo della Rivoluzione Industriale. Nasceva un nuovo approccio di tipo scientifico rispetto alla produzione, con una susseguente suddivisione delle attività produttive, e la necessità che il tecnico svolga una funzione di coordinazione senza dover realizzare in prima persona il prodotto stesso.

Inoltre, la produzione industriale, nel giro di pochi anni, subì un processo di standardizzazione che implicò l’adeguamento a precise specifiche tecniche nella realizzazione del prodotto, la cui produzione era scomposta in un insieme di passaggi più semplici, secondo un rigoroso schema concettuale. Non fu più necessario che il singolo operatore conoscesse la tecnica necessaria alla realizzazione di tutto il manufatto, come faceva un artigiano; per l’operaio fu sufficiente conoscere come svolgere la singola operazione, nella quale diventava esperto per effetto delle numerose ripetizioni dell’operazione medesima. In questo senso, il primo a raggiungere un tale obiettivo era stato Brunelleschi, che nella costruzione della cupola di Santa Maria del Fiore aveva compiuto un trasferimento di conoscenze in maniera del tutto comprensibile per le proprie maestranze, che non sapevano leggere.

Fu tuttavia il libro a diventare così il mezzo fondamentale di divulgazione della conoscenza durante questo periodo, almeno per quanto riguarda il trasferimento di conoscenze all’interno delle scuole tecniche.

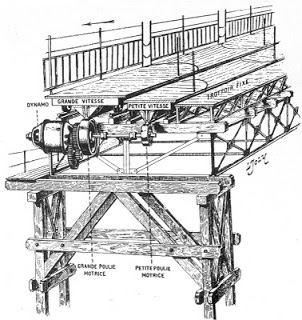

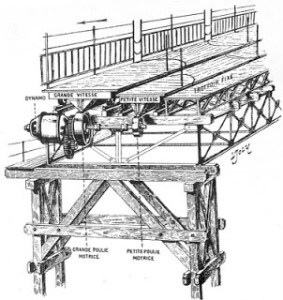

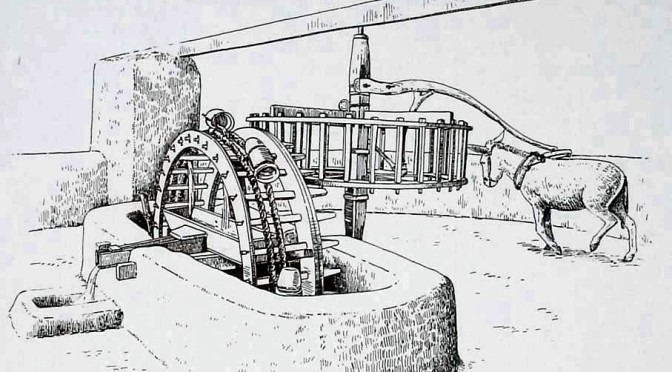

Queste nacquero grazie alla presenza di una sufficiente massa critica e quindi dopo l’avvento della tecnica del tecnico. Anche in questo caso fu l’Inghilterra a precedere gli altri paesi industrializzati con il suo il suo stretto approccio tra teoria e pratica che consentiva la formazione di una classe di tecnici adeguatamente preparati alla realtà industriale. In Francia, così come in Italia, l’aspetto teorico era stato ritenuto a lungo preponderante rispetto a quello pratico. Questo fatto viene sottolineato da Denis Diderot in suo saggio su “Le Arti” del 1752 e ribadito ancora nell’Encyclopédie (1751-1777) a cui Diderot lavorò insieme a D’Alembert; l’opera andava idealmente oltre i teatri di macchine, presentando descrizioni articolate nella parte testuale e rappresentazioni di scene operative, assonometrie, sezioni e spaccati nella parte cosiddetta delle Planches.

L’Inghilterra rappresentava un caso particolare nel panorama internazionale, perché non vi nacquero delle vere e proprie scuole tecniche ma delle associazioni, come ad esempio la “Lunar Society”. Questa associazione fu frequentata da importanti tecnici e scienziati dell’epoca, come ad esempio James Watt ed il suo sodale Matthew Boulton, o come Erasmus Darwin (nonno del più celebre Charles) e Josiah Wedgewood (il nome fondamentale nell’industrializzazione dell’industria delle ceramiche), che discutevano e scambiavano le proprie esperienze sulle nuove tecniche applicate.

In altri paesi come la Francia, invece, fu lo Stato stesso a farsi carico dell’istituzione di scuole tecniche e scientifiche: i principali settori di applicazione furono quello delle infrastrutture (specialmente in campo militare con la fondazione dell’Ecole du Génie Militaire a Mézières, nel 1748), dell’ingegneria navale (l’Ecole Royale des Ingenieurs Constructeurs de Vaisseux, che divenne poi l’Ecole du Génie Maritime, fu fondata nel 1765), e quello minerario (risale al 1748 al 1783 l’istituzione dell’Ecole des Mines).

Durante questo periodo assume grande importanza la figura del geniere, ossia colui che si occupava delle infrastrutture e del loro contenuto tecnologico: in marina si occupava dell’adeguamento dei sistemi di bordo della nave, mentre in ambito terrestre era fondamentale per la costituzione delle infrastrutture in corrispondenza della zona di avanzamento di un esercito, oltre a curarsi della logistica e degli approvvigionamenti e per garantire un’avanzata sicura.

Durante questo periodo assume grande importanza la figura del geniere, ossia colui che si occupava delle infrastrutture e del loro contenuto tecnologico: in marina si occupava dell’adeguamento dei sistemi di bordo della nave, mentre in ambito terrestre era fondamentale per la costituzione delle infrastrutture in corrispondenza della zona di avanzamento di un esercito, oltre a curarsi della logistica e degli approvvigionamenti e per garantire un’avanzata sicura.