L’introduzione dei transistor al posto delle valvole, all’interno del computer, aumentò notevolmente la velocità di elaborazione dei dati e permise di ridurre notevolmente le dimensioni, nonché i guasti.

Il passo ulteriore fu la realizzazione di un certo numero (che crebbe in pochi anni) di transistor sullo stesso supporto. Nel 1958, nei laboratori della Texas Instruments di Dallas, l’ingegnere Jack S. Kilby riuscì per la prima volta a combinare in una sola unità monolitica compatta le funzioni di bobine, transistori, condensatori e resistori, il tutto a partire da un solo materiale, il germanio (sostituito successivamente con il silicio): nasceva il circuito integrato.

Il germanio, così come il silicio, sono dei semiconduttori; si comportano cioè in modo diverso secondo la corrente dalla quale sono attraversati. Così come un diodo, possono essere conduttori o isolanti, semplicemente in funzione delle caratteristiche elettriche dei segnali che li attraversano.

Il transistor non ebbe immediata fortuna negli Stati Uniti, tanto è vero che il primo vero utilizzatore in grande scala di questo dispositivo fu il Giappone, che anzi basò buona parte della sua crescita industriale sulla nascente industria elettronica. Le applicazioni del transistor furono le più disparate, anche se il linguaggio comune registra quelle di maggior impatto: “transistor” per una persona che sia stata giovane negli anni ’60, può semplicemente voler dire “radiolina portatile”.

Si dovrà tuttavia attendere il 1964 per vedere il primo computer a circuiti integrati, l’IBM modello 360, che segnò l’avvento del computer di “terza generazione”. Con questa si passava dalle 2.200 moltiplicazioni al secondo del computer di prima generazione, alle 38.000 della seconda, ai due milioni della terza, con costi che erano scesi di oltre cento volte. Lo sviluppo era vertiginoso: l’ENIAC impiegava tre secondi per moltiplicare due numeri di 23 cifre e un minuto e mezzo per calcolare un logaritmo fino alla ventesima cifra decimale, a fronte rispettivamente dei millisecondi e dei centesimi di secondo della serie 360 IBM.

Sino alla metà degli anni ’50 il batch processing era l’unica modalità di lavoro dei calcolatori elettronici: essi potevano svolgere una sola operazione alla volta, con sprechi di efficienza.

E’ evidente come le operazioni eseguite secondo la logica del flusso continuo (del tutto analogo al principio che governa la catena di montaggio) risultino molto convenienti per tempo impiegato e occupazione della potenza di calcolo del processore.

Le dimensioni degli elaboratori, poi, erano sempre maggiori, con notevole emissione di calore. Si resero sempre più necessari degli ambienti a temperatura controllata, in grado di difendere i componenti elettronici da rotture da stress termico. Ciò, tuttavia, allontanò fisicamente gli elaboratori dai loro utilizzatori, in un momento nel quale gli input erano forniti a mezzo di schede perforate, che spesso potevano portare errori.

Nel 1957 fu realizzata per la prima volta una connessione remota ad un calcolatore elettronico: essa consentì agli utenti di lavorare pur non nelle prossimità fisiche della macchina. Nel contempo, fu realizzato un elaboratore in grado di lavorare non solo per batch processing: non solo si poterono far eseguire diverse operazioni in modo parzialmente sovrapposto, ma soprattutto fu possibile far utilizzare la potenza di calcolo a più utenti contemporanei.

Il 1957 è anche l’anno del lancio dello “Sputnik” (4 ottobre), che portò Yuri Gagarin nello spazio. La paura di una supremazia russa indusse il governo americano alla formazione di un ente, il DARPA (Defence Advanced Research Project Agency), nel febbraio 1958.

Primo progetto perseguito dal DARPA fu la formazione di una rete di elaboratori, utile a:

– accelerare lo scambio di informazioni;

– evitare la replica di queste.

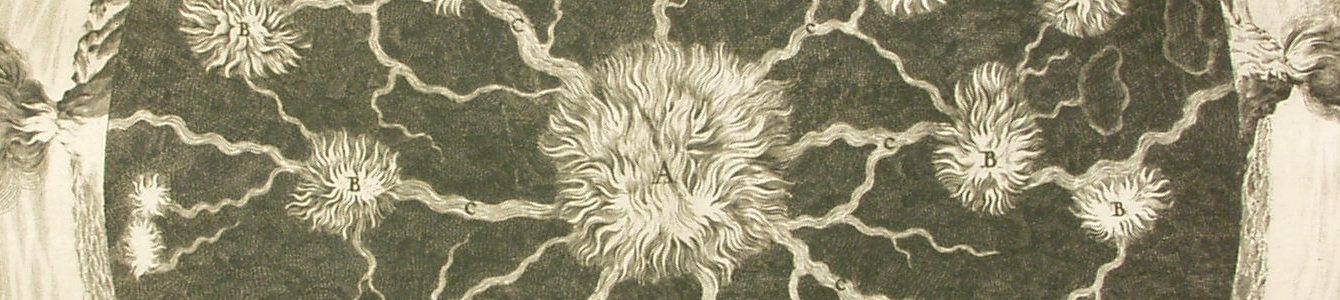

Ulteriore motivazione per la ricerca nel campo delle reti di elaboratori apparve nel 1962, quando la Difesa americana prese coscienza che le postazioni missilistiche situate a Cuba minacciavano il suolo degli USA. Insieme con altre problematiche vi era quella della connessione tra nodi della rete di computer. Questa, basata sulle onde lunghe, in caso di attacco nucleare avrebbe funzionato in modo migliore. La struttura della rete era inoltre ridondata, per resistere alla soppressione di uno o più nodi.